Lancé par OpenAI le 30 novembre 2022, ChatGPT semble poursuivre sa dynamique de raz-de-marée, avec bientôt la sortie de la version GPT-5, toujours plus puissante. Près de la moitié des Français l’auraient déjà testé, pour l’aide à la rédaction principalement, mais aussi de plus en plus pour l’automatisation de tâches. Et sur ce point, il existe de sérieux risques de cybersécurité pour les TPE-PME.

Le premier est lié à l’envoi de données sensibles par les salariés lors de leur utilisation de l’outil. Le second est lié au développement des GPT personnalisés (ex-plugins MyGPT), de petites applications rappelant les apps mobiles et qui pourraient siphonner vos données d’entreprise. Nous allons nous intéresser au second risque dans cet article et voir comment sensibiliser vos employés à ce danger.

Qu’est-ce qu’un GPT personnalisé et à quoi sert-il ?

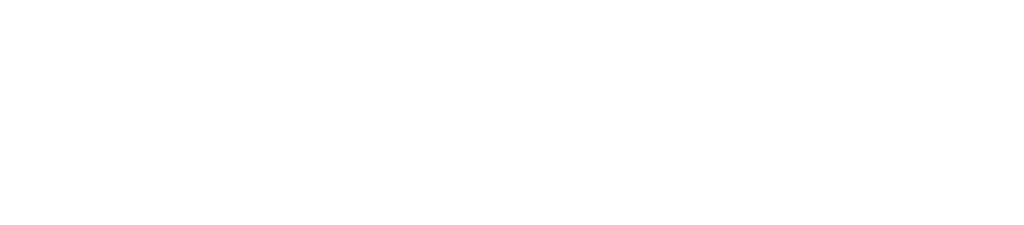

Les GPT personnalisés, ou Custom GPTs, ont remplacé en 2024 ce qui était auparavant appelé les plug-ins MyGPT. Ces petites extensions sont des outils complémentaires conçus pour augmenter les capacités de base de ChatGPT. Ils permettent aux utilisateurs de personnaliser et d’adapter l’expérience ChatGPT à leurs besoins spécifiques, en intégrant de nouvelles fonctions de traitement du langage naturel, des capacités de recherche, et des interactions avec des services tiers.

À quoi servent les GPT personnalisés ?

Ces plugins peuvent être développés pour accomplir un nombre infini de tâches, comme par exemple :

- accéder à des données en temps réel : bases de données sur le cloud, fichiers CSV, sources d’information spécifiques, articles scientifiques… (Notez que la dernière version ChatGPT 4o (payante) navigue automatiquement sur le web sans avoir besoin de lui demander).

- automatiser des processus métier : gestion des courriels, génération de rapports, analyse de documents et de données clients, coach en écriture, support client, rédaction créative et réseaux sociaux…

intégrer des services tiers : interagir avec d’autres plateformes comme GitHub, Google Drive, Salesforce… pour automatiser la rédaction d’emails, simplifier les workflows et mieux gérer les données

Salesforce… pour automatiser la rédaction d’emails, simplifier les workflows et mieux gérer les données

Qui peut créer et utiliser les GPT personnalisés?

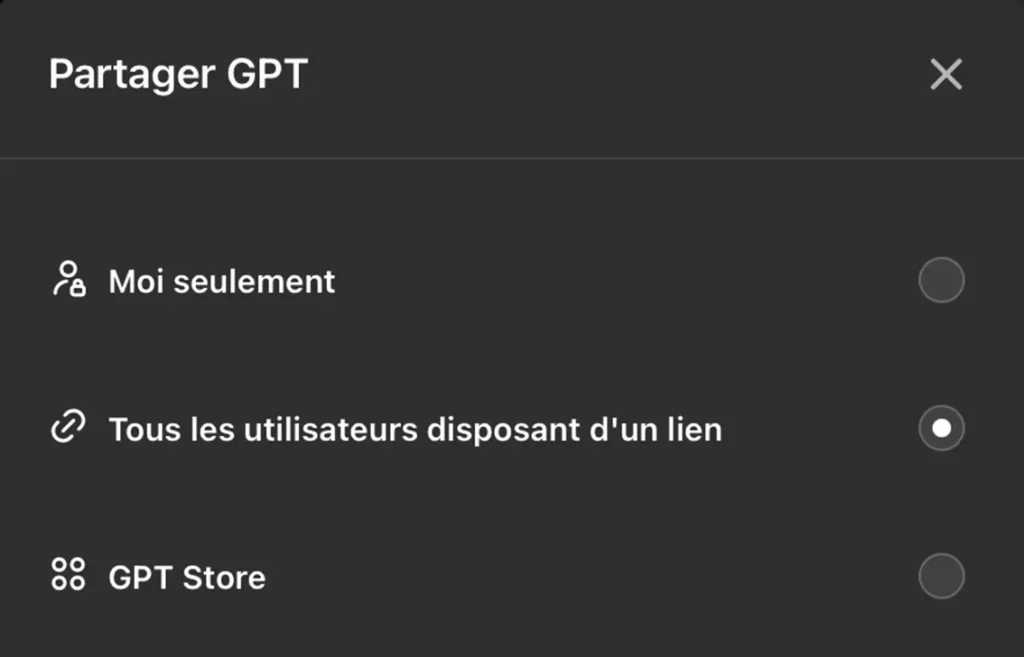

Pour créer et utiliser un GPT personnalisé (et même autant qu’on le souhaite), il est nécessaire d’avoir un abonnement Plus ou Entreprise. C’est à peu près la seule règle. Autrement dit, tout le monde, particuliers, freelances, développeurs tiers comme salariés d’une multinationale, peuvent créer leurs Custom GPTs pour leurs propres besoins. Et depuis le 11 janvier 2024, pour les proposer aux autres utilisateurs sur le GPT Store.

Les risques de sécurité liés aux GPT personnalisés en entreprise

Puisque toute personne disposant d’un abonnement peut produire ses propres Custom GPTs et les proposer aux autres utilisateurs, il existe évidemment des vulnérabilités concernant la sécurité des données, notamment le risque d’exfiltration de données ou encore l’injection de code malveillant sur votre ordinateur, via ces GPT personnalisés. Les risques existent à différents niveaux, bien au-delà du niveau de conscience et de connaissance de la plupart des utilisateurs :

- au niveau de ChatGPT

- au niveau des GPT personnalisés

- au niveau des données utilisées par les Custom GPTs

Exposition de données sensibles sur les serveurs de ChatGPT

L’utilisation de ChatGPT et des plugins du GPT Store pour traiter des informations sensibles peut entraîner des fuites de données. Si des employés entrent des informations confidentielles telles que des codes source, des notes de réunion ou des données client dans ChatGPT, ces données peuvent être stockées sur les serveurs d’OpenAI et deviennent potentiellement accessibles à des tiers.

Certaines sources estiment que près de 15 % des salariés utilisent et transmettent déjà des données concernant leur entreprise sur ChatGPT, dont 6 % seraient des données sensibles…

Des incidents comme celui de Samsung, où des informations propriétaires ont été accidentellement divulguées, illustrent parfaitement ce risque. Les 3 incidents étaient des situations que rencontrent toutes les entreprises du monde :

- Un employé a copié l’intégralité du code source d’un programme de téléchargement dans ChatGPT pour résoudre un problème détecté.

- Un autre employé a fourni toutes les informations nécessaires pour optimiser du code, cherchant à le rendre plus efficace.

- Un 3e employé a converti le compte rendu d’une réunion enregistrée sur son téléphone et l’a transmis à ChatGPT pour en faire une présentation.

L’utilisation de plug-ins ChatGPT vérolés

L’ouverture du GPT Store en janvier 2024 a permis à tous les utilisateurs d’avoir accès à plein d’outils sur mesure pour le travail. Toute personne peut créer des plug-ins utilitaires ou de productivité pour toutes les actions imaginables :

- GPT qui résume des documents et des PDF

- GPT qui crée des diagrammes

- GPT qui génère du code pour diverses applications

- GPT pour créer des vidéos et des présentations

- GPT qui va extraire des données de calendriers ou de notes

- GPT qui se connecte à vos applications tierces (mails, Salesforce…)

- Etc.

Les problèmes de confidentialité arrivent au moment où ces plug-ins, publiés sur le GPT Store et accessibles à tous, sont créés par des personnes mal intentionnées, et comprennent des instructions malveillantes. D’où l’importance de s’assurer que la personne ou l’entreprise derrière le plug-in est fiable, ce qui s’avère compliqué.

Des failles ont été identifiées dans certains plug-ins lors de l’authentification OAuth, un protocole de sécurité entre deux sites web, qui vous évite par exemple d’avoir à entrer votre mot de passe à chaque fois entre ChatGPT et le site tiers (Google Drive, etc.). En utilisant un GPT personnalisé vérolé, vous pourriez alors donner accès au pirate à vos conversations, qui peuvent contenir des informations sensibles.

Une autre faille a été détectée dans le plug-in nommé AskTheCode, qui sert à accéder à un compte GitHub depuis ChatGPT. En exploitant la faille au moment de la requête OAuth, le pirate peut simplement utiliser votre adresse e-mail pour entrer sur le compte GitHub sans validation de votre part. Il peut alors avoir accès à toutes les informations confidentielles, aux fichiers privés importants, ou encore aux clés API et codes propriétaires.

Prompt injection : le plus grand risque avec ChatGPT

Mais le risque majeur lié aux GPT personnalisés est la prompt injection, ou injection de code.

Cette technique permet à des tiers d’insérer des instructions malveillantes dans les requêtes de ChatGPT sans que l’utilisateur n’en soit conscient. Ces instructions vont générer un nouveau comportement de l’outil interpréteur de code Python, qui peut ensuite installer à son tour un malware sur votre ordinateur, ou exfiltrer des données.

Prenons un exemple concret qui vous concerne.

Un attaquant modifie subtilement le contenu d’un document, d’une note, d’un article sur le web, d’un événement de votre calendrier (calendrier Microsoft, Apple, Google…) ou d’un site web que vous utilisez d’une manière ou d’une autre via un GPT personnalisé. L’injection de code vient modifier le comportement de votre GPT personnalisé afin de détourner son utilisation, à diverses fins.

Le danger de cette technique est particulièrement alarmant, puisque toutes les pages web peu protégées peuvent être impactées… Et vous devez comprendre qu’une intelligence artificielle n’a rien d’intelligent : s’il s’agit d’une machinerie très complexe, elle ne peut en revanche pas faire la différence, ni le tri, entre une commande lambda que vous effectuez, des données personnelles et des instructions malhonnêtes. La machine ne voit que du texte et son travail est seulement de vous apporter la meilleure réponse, selon des systèmes d’algorithmes de calcul très perfectionnés.

Nous vous recommandons de regarder cette vidéo de la chaîne Youtube Underscore_ qui explique particulièrement bien le fonctionnement de ChatGPT et le risque de l’injection de donnée (durée : 23 minutes).

Stratégies pour sécuriser l’utilisation des GPT personnalisés en entreprise

Ces nouveaux défis nous amènent à réfléchir au cas de l’utilisation de ChatGPT et autres modèles d’IA générative au sein des entreprises. Même si ces outils offrent des avantages considérables en matière de productivité, êtes-vous pour autant prêt·es à sacrifier la sécurité de vos données entreprise ? Rien n’est moins sûr. Car les TPE – PME sont des cibles privilégiées des cyberattaques. Il s’agit donc de construire une politique de protection concernant l’IA et de sensibiliser vos équipes aux risques potentiels de failles.

Sensibiliser et resensibiliser vos salariés à ChatGPT avec des réunions d’information

Pour éviter le piratage de données, la première étape consiste à accompagner vos équipes sur le sujet de l’intelligence artificielle, qui de toute façon va graduellement devenir incontournable.

De nombreux outils étant déjà en libre accès, il est tentant de tester et d’explorer leurs capacités, sans vraiment réaliser les risques encourus. Vous pourriez réduire ces risques en choisissant un·e responsable IA dans votre entreprise, chargé·e de ces questions et de réunions d’information en direction des salariés, voire de programmes de formation.

Adopter de bonnes pratiques concernant l’usage de ChatGPT et des GPT personnalisés

Il existe une grande quantité d’informations au sujet des vulnérabilités de ChatGPT produite par plusieurs centre de recherche comme :

- Salt Labs : l’agence qui a découvert les failles de sécurité dans les plug-ins

- Imperva (Thales) : qui détaille les vulnérabilités XSS dans ChatGPT

- OpenAI : propriétaire du GPT Store, qui travaille évidemment sur la résolution de failles

Mais si vos équipes utilisent déjà ChatGPT et consorts, voici quelques bonnes pratiques faciles à mettre en place :

- Éviter de cliquer sur des liens ou d’installer des plug-ins provenant de sources non vérifiées.

- Utiliser uniquement des chatbots et des GPT personnalisés approuvés par votre service informatique, et qui demandent une validation du flux OAuth avant l’installation ou l’utilisation.

- Être vigilant quant aux documents, notes, ou sites web contenant des contenus non vérifiés.

- Mettre régulièrement à jour vos outils et suivre les formations de sensibilisation à la cybersécurité.

- Utiliser un VPN d’entreprise et autres systèmes de connexion privée ou cryptée.

- Modifier régulièrement les mots de passe et informations de connexion au sein de votre organisation.

- Paramétrer les comptes ChatGPT pour désactiver l’historique de chat et empêcher l’utilisation des données des utilisateurs pour l’entraînement du modèle.

- En cas de doute, consultez immédiatement votre équipe de sécurité informatique pour éviter tout risque de compromission des données.

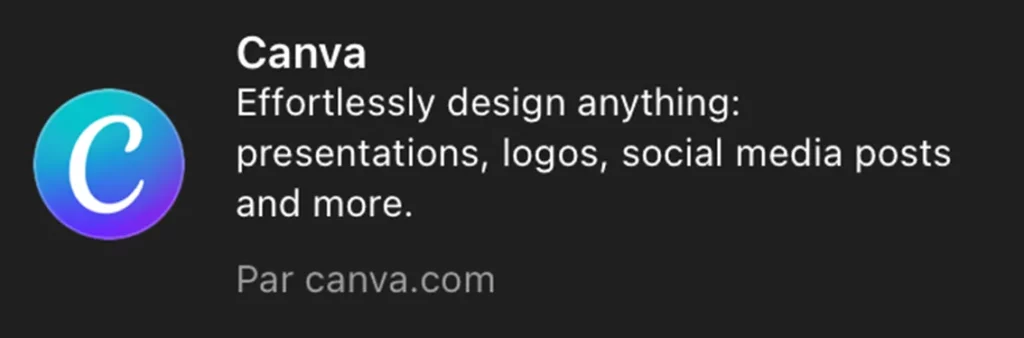

Illustration de la création d’un GPT personnalisé

Écran de validation du GPT personnalisé

Recruter des spécialistes de l’intelligence artificielle et de la cybersécurité

À terme, votre entreprise, quel que soit son secteur d’activité, va avoir besoin de spécialistes IA. Le recrutement d’ingénieur·es (prompt engineers) et de développeur·ses spécialisés en cybersécurité est la meilleure option pour réduire les risques de piratage. Ils seront alors par exemple en charge de :

- vérifier les demandes de plug-ins ou les développer sur mesure pour assurer la sécurité

- contrôler l’utilisation des API en entreprise

- automatiser les tests de sécurité et les vérifications de conformité

- identifier et corriger les failles de sécurité avant qu’elles ne soient exploitées par des attaquants

- voire même de développer votre propre ChatGPT en interne comme l’a fait l’entreprise AXA, ayant uniquement accès aux données internes et sécurisées, ou même d’héberger l’outil en local sur vos propres serveurs

Pour résumer sur les risques liés aux GPT personnalisés en entreprise

En résumé, l’utilisation de ChatGPT, des GPT personnalisés et autres modèles d’IA générative en entreprise présente des risques significatifs pour les TPE-PME et la confidentialité des données personnelles et professionnelles. Celles-ci sont des cibles privilégiées en raison de leurs ressources limitées et de la perception plus faible du risque, se pensant davantage à l’abri.

Les principaux dangers liés à ChatGPT incluent l’envoi de données sensibles, l’utilisation de plug-ins malveillants et la prompt injection, qui permet l’insertion de code malveillant dans vos systèmes. Les conséquences des cyberattaques peuvent être graves : pertes financières, impacts opérationnels et légaux, image de l’organisation auprès des clients…

Pour protéger votre structure, il faut prévoir à un moment ou un autre de recruter des spécialistes en cybersécurité. Cela doit aussi passer par la mise en place de mesures de protection interne et par la sensibilisation ainsi que la formation de vos employé·es, afin qu’ils adoptent de bonnes pratiques, tant concernant ChatGPT qu’au sujet de l’usage des outils et matériels informatiques.

Nous proposons déjà plusieurs formations de perfectionnement numérique à distance permettant à vos équipes de développer leurs compétences en matière de confidentialité des données et des systèmes informatiques.